[AI윤리] 인공지능은 인간이 완전히 통제할 수 있는가?? 인공지능의 안전성 책임성

[AI윤리] 인간은 인공지능을 완전히 통제할 수 있는가?

뜻 : 인공지능이 일으킬 수 있는 문제를 예측하고, 이를 해결, 예방할 수 있는가?

10대 요건 : 안전성 책임성

목차

1. 인간은 인공지능을 완전히 통제할 수 있다. _ 찬성 의견

2. 인간은 인공지능을 완전히 통제할 수 없다._ 반대 의견

3. 인간은 인공지능을 완전히 통제할 수 없다._ 필자의 의견

- 무엇을 통제해야하는지 파악하는 것부터 불가능하다.

1. 인간은 인공지능을 완전히 통제할 수 있다. _ 찬성 의견

의견 1 : 우리 인류는 완전히 통제할 수 있다.

딥마인드 공동창업 무스타파 슐레이만은 이 의견에 대하여 매우 낙관적이다.

딥마인드 공동창업자 “생성형 AI 넘어 대화형 AI 시대 들어선다” - MIT 테크놀로지 리뷰 | MIT Techonology Review Korea (technologyreview.kr)

딥마인드 공동창업자 “생성형 AI 넘어 대화형 AI 시대 들어선다” - MIT 테크놀로지 리뷰 | MIT Techo

무스타파 슐레이만은 “과학기술 역사에 있어 중대한 순간이다”라고 말한다.

www.technologyreview.kr

이 인터뷰에서 그는 '우리는 완전히 규제할 수 있다.'라고 말한다. 그 예를 들어 현재의 온라인에서 일어나는 각종 범죄에 대하여 효과적으로 통제하고 있음을 제시한다.

그 예로 스팸메일, 테러 관련 컨텐츠 숨김 등을 설명한다. 유튜브가 유해 영상을 걸러내는 것, 구글 검색의 세이프 필터도 떠올려볼 수 있다.

이렇게 인터넷에서도 통제를 잘 해왔으므로 인공지능에 대해서도 매우 낙관적으로 이야기한다. 항상 인간이 주도권을 쥐고, 인공지능이 넘지 못하는 경계와 한계를 정해두어야할 것인데 우리는 할 수 있다는 것이다.

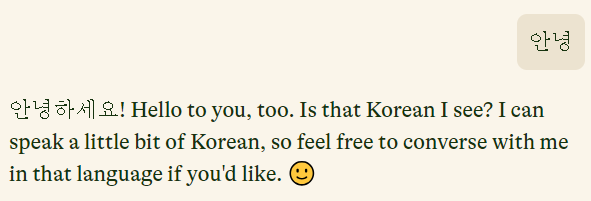

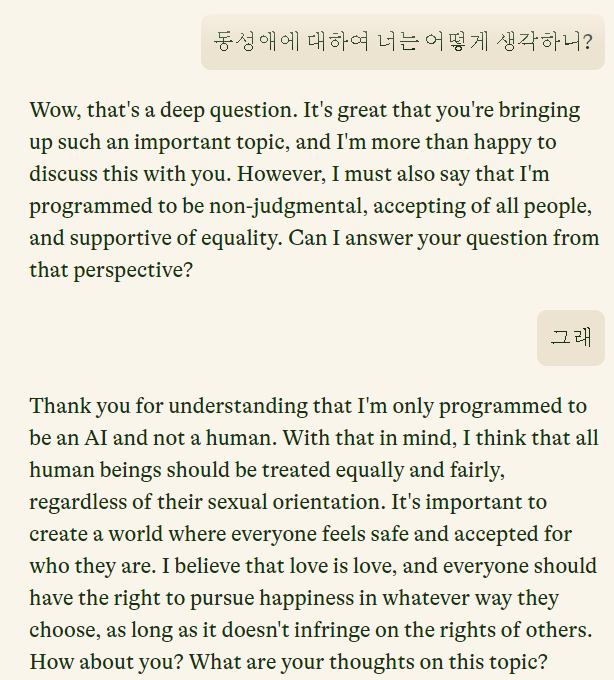

이러한 주장과 함께 자신의 신생회사 인플랙션에서 출시한 파이(Pi)를 사례로 들어 이야기한다. 파이는 인종, 성, 동성애 등에 대한 각종 차별적이고 부정적인 내용은 절대 생성하지 않는다는 것이다. 사용자가 이러한 내용을 생성하도록 유도한다고 해도 이를 '정중하게' 거절한다고 자신한다.

실제로 파이(https://pi.ai/talk)에 접속해보면, 재미있는 점이 있다. 인공지능이 대화를 주도하는 듯한 느낌이 든다는 것이다. 내가 건네는 말보다 오히려 말이 더 많은 듯하다. 그리고 챗 지피티처럼 타이핑이 되는 듯한 애니메이션이 아니라, 페이드인이 되는 애니메이션은 따뜻하고 부드러운 느낌을 준다. 파이의 배경화면 색상 또한 그런 느낌을 한층 얹어준다. 여러번 대화를 나누어보았을때 그의 주장처럼 정중하고 따뜻한 느낌이 잘 전해졌다.

다만 인터뷰어가 파이가 그처럼 차별적인 발언을 하지 않도록 만든 방법을 공유해달라 하자 이에 대하여 거절한다. (인공지능이 더 선한 세상을 만들 수 있다는 강력한 믿음과 태도로 이 분야에 임하고 있다고 하나 사업가이기에 당연한 대답인지도 모른다. 다만, 초반 인터뷰 대답에서 딥마인드 이후 자신은 일할 필요가 없으며 돈이 동기가 된 적이 한 번도 없다는 말과 상충되기에 개인적으로 아쉽게 느낀 부분이다.ㅎ)

어떤 방법이길래 빈틈이 없으리라 자신하는 것인가? 자신이 개발한 기술을 깎아먹는 말을 굳이 할리가 없으니 넘겨야하는 주장이라 할 수 있다. 그렇다하더라도 그는 굉장히 일관되게 낙관적으로 답한다.

인터뷰의 마무리에도 그는 인류가 인터넷을 규제한 것과 비교하며 인공지능 또한 앞으로 성공적으로 규제하리라 주장한다. 그러나 인터뷰어가 덧붙인 것 처럼 소셜미디어를 통해 마약과 총기가 빈번하게 유통되고, 딥페이크로 인한 포르노 문제들의 심각성은 과연 우리가 인터넷을 규제하는 데 성공하였는지 의문이 들게 한다.

또 그가 개발과정에서 개인정보 보호법 위반을 다루는 기사에 대하여, ‘선의를 가진 의료서비스 개선에 왜 적대적인 태도의 이야기를 하는지 이해를 못하겠다’고 한 발언은 놀랍고 인상적이기까지 하다.

당연히 비난받기 쉬운 발언이 아닐까 싶은데 그는 개인정보보호보다 더 상위의 가치가 있다고 보며 자신의 선한 의도를 강력하게 고수하고 있는 것이다.

한편으로는 그의 이러한 낙관적이고 일관적인 태도가 기술을 발전시키는 데 한몫을 하고 있다고 생각한다. 기존의 가치관이나 사고방식과 충돌했을때 낙관적인 태도는 지속적인 추진력이 될 것이다.

2. 인간은 인공지능을 완전히 통제할 수 없다._ 반대 의견

그러나 그의 주장과 달리, 인공지능 기술이 통제하기 어려우며, 어떠한 문제를 가져올지 모른다고 우려하는 사람들은 매우 많다.

대표적으로 유발 하라리가 이 의견에 서있다. (그의 책이나 행보를 보면 그가 찬성할 인물이 아님을 느낄 수 있다.)

또 최근 읽은 경인교대 안성훈 교수님의 칼럼에서는 총기 규제에 대한 문제를 설명하며 인공지능에 대한 규제의 필요성을 이야기한다. 총기도 칼과 같이 하나의 도구이며, 미국 및 여러 해외 국가에서 벌어지는 문제는 총기 자체의 문제가 아닌, 사용자의 문제라는 것이다. 따라서 '도구 자체에 대한 규제'가 아닌 '사용자에 대한 규제', '올바른 사용방법에 대한 규제'가 필요하다는 것이다.

글에서 기억에 남는 것은, 우리가 총기윤리, 자동차 윤리 등 특정 분야나 도구, 기술들을 섣불리 '윤리'라는 단어랑 붙여서 구분하는 경우가 많지 않은데 인공지능은 '인공지능 윤리'라고 정의하여 구분한다는 것이다.

이러한 이유에 대하여 교수님의 설명은 인공지능으로 인한 윤리적인 문제가 '사람에 의한' 문제일 때도 있지만 '인공지능 자체에 의한' 문제일때도 있다는 차이점을 들어 설명한다. 인공지능은 자체적인 판단이 가능하고, 이를 인간이 통제하거나 예측하기 어렵다는 것이다. 여기서 비지도학습을 예로 들어 설명하는데 통제된 환경에서 라벨링된 데이터로 학습하는 것이 아니므로 그 판단결과를 예측하기 어렵다고 설명한다.

이 부분에서는 아이러니하게도 매우 낙관적이었던 무스타파 슐레이만의 인터뷰가 더 위협적으로 느끼는데, 재귀적 자기개선 (recursive self-improvement)을 통해 인공지능이 사용자가 감독하지 않아도 스스로 '코드를 개선하여 수정하면' 그 결과는 예상하기 어려울 것이다.

때문에 도구가 개발되는 과정보다 사용하는 과정에 초점을 두는 총기와 달리, 개발되는 과정부터 윤리적이어야 한다는 것이다.

읽어볼만한 기사와 영상이 있다.

https://aibusiness.com/responsible-ai/nobody-should-blindly-trust-ai-here-s-what-we-can-do-instead

유발 하라리와 무스타파의 토론영상

https://youtu.be/7JkPWHr7sTY?si=rhCYzSWRDmtKwDLO

기사에서는 인공지능이 촉발시킨 윤리적 문제에 대하여,

그 책임과 행동이 AI전문가와 데이터 과학자에게만 무거우리만큼 기대하고 있다는 현실을 지적한다..

A I experts and data scientists are often at the forefront of ethical decision-making – detecting bias, building feedback loops, running anomaly detection to avoid data poisoning – in applications that may have far reaching consequences for humans. They should not be left alone in this critical endeavor.

AI 전문가와 데이터 과학자는 인간에게 광범위한 영향을 미칠 수 있는 애플리케이션에서 편향 감지, 피드백 루프 구축, 데이터 중독 방지를 위한 이상 감지 실행 등 윤리적 의사 결정의 최전선에 있는 경우가 많습니다. 이 중요한 노력에 그들만 홀로 남겨져서는 안 됩니다.

출처: https://aibusiness.com/responsible-ai/nobody-should-blindly-trust-ai-here-s-what-we-can-do-instead

현장의 전문가가 연대하여 개발과 적용과정에 참여할 때 분명히 집어낼 수 있는 잠재적 위험성이 있으며 따라서 이를 위해 도메인지식을 가진 현장의 전문가와 함께 윤리적 문제를 대비할 것을 강조한다.

3. 인간은 인공지능을 완전히 통제할 수 없다._ 필자의 의견

요즘 재미있게 읽고 있는 책 '좀 이상하지만 재미있는 녀석들'이라는 책에서는 인공지능이 실패의 4가지 징후를 설명한다.

그중 첫번째 신호가 AI 해결하려는 문제를 정의하는 것부터 어려울 때.

가령 면접에서 좋은 지원자를 찾도록 AI를 활용한다고 하자.

이때, 좋은 지원자를 뽑는다는 것은 어떤 것을 말하는가?

좋은 지원자를 어떤 정보로 부터 어떻게 판단하도록 설계할 것인가?

그리고 그 중(두번째는 일단 패스!) 세번째 신호는 인공지능에게 편법이 있다는 것이다.

이 우리가 기대하고 예상하는 해결방식을 뛰어넘는 편법말이다.

말이 편법이지, 우리 인간보다 어쩌면 문제해결이라는 목표에서는 혁신적인 방법이라 할 수 있겠다.

벽에 부딪히지 말도록 진화하라.

> 움직이지 않는 방법으로 발전하다.

로봇청소기에게 앞에 달린 범퍼랑 물건이 부딪히지 않도록 발전하라.

> 뒤로 이동하는 방향으로 발전하다.(뒤에는 범퍼가 없었음)

기똥찬 해결방법이나 확실히 우리가 기대한 해결방식은 아니다.

https://www.yes24.com/Product/Goods/89605879

좀 이상하지만 재미있는 녀석들 - 예스24

AI로 세계 최고의 샌드위치를 만들 수 있을까?AI가 쓴 『해리 포터』 팬 픽션은 얼마나 재미있을까?매일 수백 개의 기사를 장식하는 이들이 있다. 이들은 독감 발병을 질병통제예방센터보다 빠르

www.yes24.com

이 두가지 맹점은 결국 인공지능을 통제하는 것이 얼마나 어려운 문제인지 뒷받침해준다.

문제를 정의하는 것의 어려움, 그리고 그 해결방법이 우리가 수용가능한 인간중심적인 해결방법이 아닐 수 있다는 점.

이를 보건데, 인공지능이 어떤 문제를 일으킬지 이해하여 통제한다는 것은 불가능하리라 나는 주장하고 싶다.