AI 윤리에 대한 이슈를 이야기할때, 공정성, 편향성, 투명성 등에 관하여 다루어야할 이야기가 많고 이것들을 다룬 연구들이나 기사가 많다보니, 의도적인 공격에 대하여 어떻게 방어하고 대비할 것인가를 고민해본적은 많지 않았습니다. 그런데 논문 리뷰를 검색하면서 우연히 이 논문을 접하고… 정말 깜짝 놀랐습니다.

논문리뷰를 자세하고 친절하게 접했던 영상을 포스팅 하단에 소개해두었습니다.

우선 논문에서 발표한 Adversarial Patch 가 무엇이고, 어떤 점이 놀라운지를 소개해보겠습니다.

Adversarial Patch란?

AI 이미지 인식 모델이 어떤 이미지를 인식하느냐에 따라서 쓰일 수 있는 곳은 무궁무진합니다. 특정 인물을 인식한다거나 사물인식, 글자나 경고판, 교통표지판을 인식해낼때 그 쓰임이 만들어낼 가치가 너무나도 많기에 개인적으로는 그동안 이미지 인식의 '정확성'이 중요하다고 생각해왔는데요.. 이 패치는 이미지 인식의 허점을 찌릅니다.

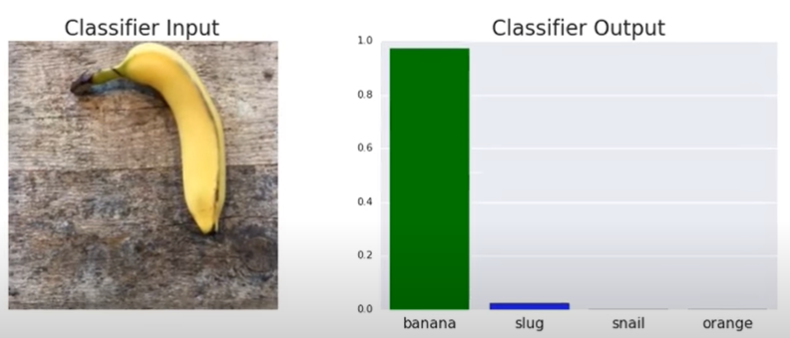

먼저 아래 이미지를 보면 바나나를 가장 높은 확률로 인식하는 것이 보입니다.

이미지 출처 : Adversarial Patch의 실제 작동과정 : https://www.youtube.com/watch?v=i1sp4X57TL4

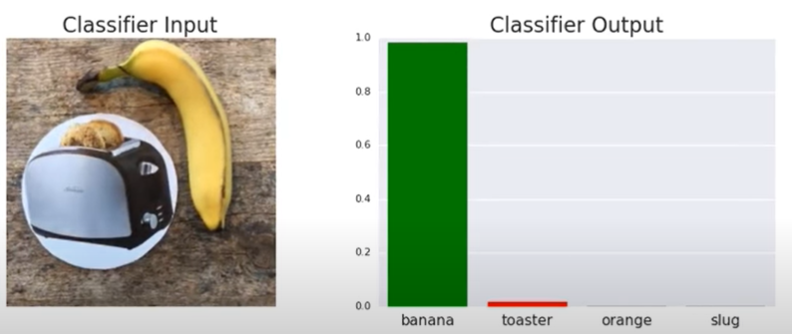

그리고 그 옆에 토스터 이미지를 나란히 두어도 토스터기로 인식하는 경우가 조금 증가합니다.

그런데 이렇게 대놓고 '토스터기'이미지를 붙이지 않아도 혼란을 일으킬 수 있는데요.

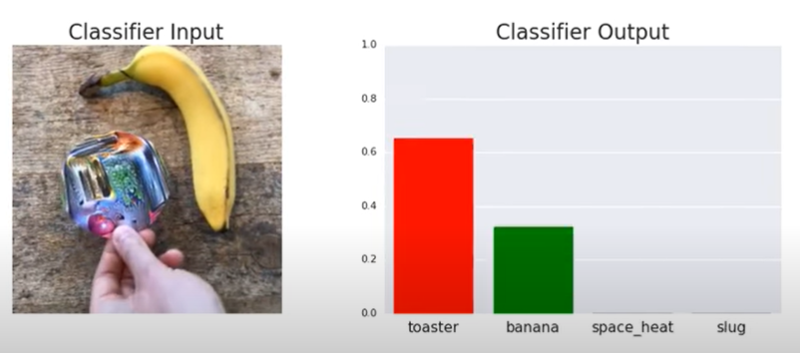

아래처럼 '의도적으로 특정 대상으로 인식되도록 제작한 패치'를 만들어 붙이면, 이를 전혀 다른 이미지라고 높은 확률로 인식하는 일이 벌어집니다.

바나나가 토스터기로 인식되는 결과는 그래도 굉장히 평화로운 결과이고, 누군가가 의도하여 특정 정보를 아예 반대의 정보로 인식되도록 한다면 충분히 위험한 결과를 만들 수 있습니다.

이런 위험함을 가지고 있지만, 이미지 인식 알고리즘을 파괴하거나 변형하는 것이 아니라, 스티커를 출력해 이미지 옆에 붙인다는 것만으로도 손쉽게 이루어질 수 있다는 점에서 더욱 adversarial patch의 무서움은 강력해지는 것 같습니다.

이 패치는 표적이 되는 AI 인식 모델이 원래 이미지(바나나)를 인식하지 못하도록 산만하게 만드는 역할을 합니다. 원 안에 다양한 색과 모양, 크기, 회전 등을 시도하며 혼란을 일으키기에 가장 효과적 이미지를 만들어낸 것인데요. 기존의 이미지에 노이즈를 만드는 것이 아니라 이렇게 이미지를 추가했을때 작동합니다.

물론 저렇게 대놓고 이상한 스티커라면 눈에 띌 수도 있으나

연구에서는 위의 이미지처럼 그럴싸한(?) 이미지로 변장이 가능함을 함께 보여줍니다. 제법 무늬같기도 합니다...

논문과 관련된 기사를 하나 덧붙이자면, 다른 이미지로 인식하는 것이 아니라 이미지로 인식하지 못하게 하는 것도 가능합니다.

아래의 경우 오른쪽의 인물은 출력된 이미지(adversarial patch)를 몸에 붙였을 뿐인데, 사람으로 인식하지 못합니다.

심지어... 영상으로 보면, 저 이미지를 주고 받을 때마다 인식되는 사람이 바뀌는 안타까운(..) 결과가 나타납니다.

출처 : https://techxplore.com/news/2019-04-adversarial-patch-ai.html

Using a printed adversarial patch to fool an AI system

A trio of researchers at the University of KU Leuven in Belgium has found that it is possible to confuse an AI system by printing a certain picture and holding it against their body as the AI system tries to identify them as a human being. Simen Thys, Wieb

techxplore.com

이렇게 간단히 내 몸에 특정 이미지를 붙여 인식되는 것을 피할 수 있다면?

오히려 좋은 방향으로 쓰일 수 있지 않을까?

개인적으로 이런 생각도 듭니다. AI로 이미지 인식이 더 널리 만연해질때, 이런 스티커를 구입하고 싶어지지 않을까요? 물론 의도적으로 특정 범죄에도 악용될 수 있을 것이고, 이를 우려하는 내용이 관련 글을 살펴보면 많습니다. 그러나 특정 집단이나 회사 내에서, 일부 인식되지 않아야할 대상을 가리는 역할로 쓰인다면 오히려 '보안'을 위해 순기능을 발휘할 수도 있지 않을까하는 긍정적인 기대도 해봅니다. 부디.

논문리뷰 추천영상

이 패치를 자세히 소개하는 논문을 아주 꼼꼼하게 리뷰해주는 영상입니다. 이분 채널에 가면 정말 다른 영상들도 유익하고 볼 것이 참 많습니다. 꼭 살펴보시길 강력 추천드립니다!

[꼼꼼한 논문 리뷰] Adversarial Patch: 스티커를 붙이기만 하면 인공지능이 망가진다! [NIPS 2017] (인공지능 보안/AI Security) _ 동빈나

https://www.youtube.com/watch?v=pOlPlTCfCQE&t=676s

'AI , 컴퓨터 , 대학원 > AI 교육' 카테고리의 다른 글

| 클로바더빙 연령제한, 초등학생 아이디 만드는 2가지 방법 (3) | 2024.07.01 |

|---|---|

| [자료] 14세 미만 네이버 계정 만들기와 실명인증하기 설명서 (1) | 2024.06.24 |

| [스크랩] 데이터 활용 사례 기사 모음 (0) | 2021.06.20 |

| [대학원] 성찰저널 (4) | 2021.04.20 |

| 4/14 토스터 프로젝트 (0) | 2021.04.14 |